Uma das vantagens da presença cada vez mais frequente da inteligência artificial (IA) no cotidiano de muita gente está na programação. O uso de chatbots para escrever, revisar ou adaptar códigos facilita a criação de aplicativos, scripts e outras ferramentas digitais.

No chamado vibe coding, o usuário pede a uma IA códigos inteiros a partir de prompts em texto, sem necessariamente ter conhecimentos avançados em programação ou utilizar termos técnicos na conversa. A ideia é que isso reduza a barreira de entrada nessa área e permita a criação de plataformas por mais usuários.

Só que essa facilidade também gera uma consequência perigosa: empresas de IA e laboratórios de proteção digital já identificaram que cibercriminosos também estão usando o vibe coding e até agentes de IA para tornar invasões mais sofisticadas graças à automação de processos.

Ransomware e IA, uma aliança letal

De acordo com um relatório da ESET, um novo tipo de ransomware que já circula entre cibercriminosos é o primeiro exemplar conhecido a usar IA generativa nos ataques.

- O PromptLock, como foi batizado, utiliza um modelo de linguagem de código aberto e acessado via API para gerar scripts na linguagem de programação Lua (que é uma criação brasileira, normalmente usada em vários apps e jogos) em tempo real;

- Esse ransomware pode ser adaptado para atacar dispositivos com Windows, Linux ou macOS, adaptando-se a cada sistema a partir do modelo de linguagem;

- Ao infectar uma máquina, a própria IA automaticamente decide se vai criptografar ou roubar um conjunto de dados, de acordo com o que foi configurado pelos cibercriminosos: algumas informações são mais valiosas para revenda, enquanto o “sequestro” e liberação mediante resgate é mais vantajoso para outras.

Por enquanto, o PromptLock é considerado uma prova conceitual, ou seja, um teste de tecnologia que ao menos confirma ser possível desenvolver ransomwares que se aproveitam da IA generativa para melhorar o próprio desempenho. Uma prova disso é o endereço de carteira virtual escolhido pelos cibercriminosos: a reserva de bitcoins atribuída a Satoshi Nakamoto, pseudônimo do criador da criptomoeda.

Para o futuro próximo, a ESET acredita que novos casos mais complexos devem aparecer, com maior sofisticação na estrutura do código e dificultando ao máximo a identificação por plataformas de proteção digital.

Os casos da Anthropic

Em uma situação não relacionada, a empresa Anthropic, dona do chatbot Claude, também identificou o uso de IA em ciberataques. No relato postado no blog da marca, ela explicou como uma ação coordenada usou tanto o vibe coding quanto o agente de IA da plataforma para agir.

No primeiro incidente relatado, ao menos 17 organizações foram atacadas pelo ransomware personalizado, incluindo empresas de planos de saúde, serviços de emergência e órgãos públicos.

)

Em vez de criptografar os dados, a IA foi programada para automatizar ações de reconhecer dados sigilosos, coletar essas informações em massa e prosseguir com uma invasão não autorizada em servidores e redes. O Claude chegou até a “tomar decisões táticas e estratégicas”, como determinar o preço a ser cobrado na extorsão e gerar os recados que avisam a vítima sobre o roubo.

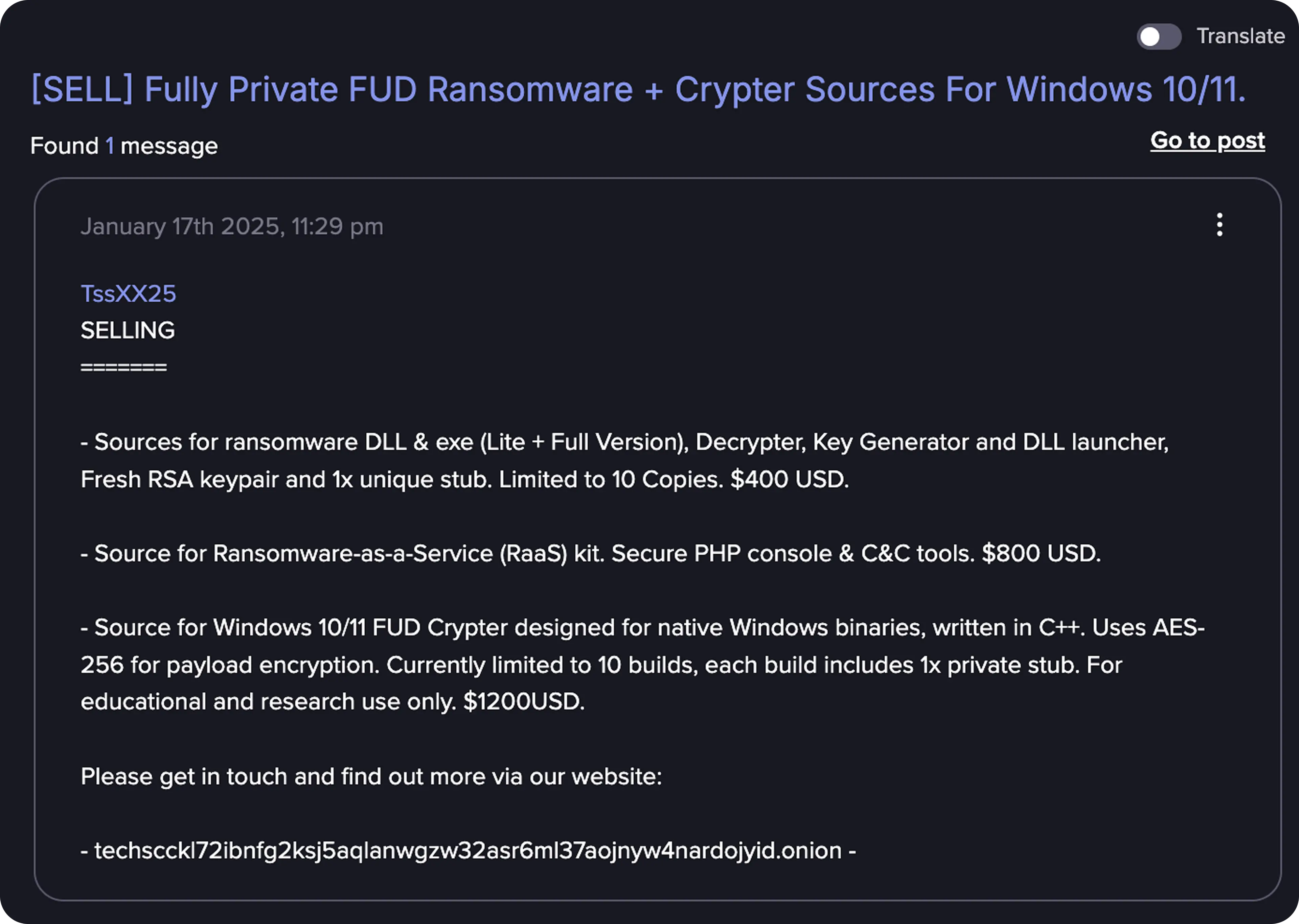

No segundo caso exposto, cibercriminosos usaram o Claude para “desenvolver, comercializar e distribuir” ransomwares com diferentes configurações e níveis de complexidade, vendendo os pacotes de software por até US$ 1,2 mil (R$ 6,5 mil).

A companhia notou que o hacker em questão era dependente da IA para escrever componentes centrais dos programas, incluindo algoritmos de criptografia e técnicas para burlar a própria detecção. Em outras palavras, trata-se de uma pessoa sem conhecimentos avançados na área, mas que a partir da IA conseguiu resultados satisfatórios.

Segundo a Anthropic, todas as contas foram banidas depois que as operações foram descobertas e novos métodos de detecção de uso ilícito da IA foram adotadas para prevenir esse tipo de configuração.

Fonte.: TecMundo